Imperva Incapusla hat heute seinen Bot-Traffic Report für 2015 vorgestellt. Der Bot-Traffic Report ist eine statistische Studie über die normalerweise nicht wahrnehmbare Bot-Traffic-Landschaft und erscheint bereits im vierten Jahr. Seitdem Imperva Incapsula zum ersten Mal offengelegt hat, dass Bots für einen Hauptanteil des weltweiten Website-Traffics verantwortlich sind, hat sich die Berichterstattung intensiviert.

Mittlerweile erscheinen regelmäßig verschiedene Artikel, die sich mit einzelnen Bots auseinandersetzen: Mit HTTP-Footprints, deren Herkunft und den Nuancen ihres Verhaltens. Grundsätzlich werden diese automatisierten Computerprogramme jedoch in zwei Archetypen unterteilt: Gute Bots und schlechte Bots.

Bot-Traffic-Report 2015: Menschen erobern das Web zurück

Der Bot Traffic Report von Imperva Incapsula ist eine statistische Studie über die normalerweise nicht wahrnehmbare Bot-Traffic-Landschaft und erscheint bereits im vierten Jahr. Seitdem Imperva Incapsula zum ersten Mal offengelegt hat, dass Bots für einen Hauptanteil des weltweiten Website-Traffics verantwortlich sind, hat sich die Berichterstattung intensiviert. Mittlerweile erscheinen regelmäßig verschiedene Artikel, die sich mit einzelnen Bots auseinandersetzen: Mit HTTP-Footprints, deren Herkunft und den Nuancen ihres Verhaltens. Grundsätzlich werden diese automatisierten Computerprogramme jedoch in zwei Archetypen unterteilt: Gute Bots und schlechte Bots.

Gute Bots sind wie Arbeiterbienen, die dem Internet bei seiner Evolution und beim Wachstum helfen. Ihre Eigentümer sind legitime Unternehmen, die Bots verwenden, um mit ihrer Hilfe automatisierte Aufgaben, einschließlich Datenerfassungen und Website-Scans durchzuführen.

Schlechte Bots hingegen sind wie böswillige Einbrecher, die das Internet überschwemmen und eine nachverfolgbare Spur von gehackten Websites und zerstörten Services hinterlassen. Ihre Drahtzieher sind die schlechten Akteure der Cybersicherheitswelt, wie professionelle Hacker und Scriptkiddies. Sie nutzen Bots für Spam-Kampagnen, das Ausspionieren von Mitbewerbern, für Denial-of-Service-Attacken (DDoS) oder um Sicherheitsscans durchzuführen und Websites in großem Stil zu kompromittieren.

In der Vergangenheit sind gute und schlechte Bots immer für einen Großteil der Tätigkeiten im firmeninternen Netzwerk von Imperva Incapsula verantwortlich gewesen. In diesem Jahr jedoch, wurde eine Wachablösung durch Menschen festgestellt, die ganz offensichtlich das Ziel haben, die neue Mehrheit im Internet zu bilden.

Menschen erobern das Internet zurück

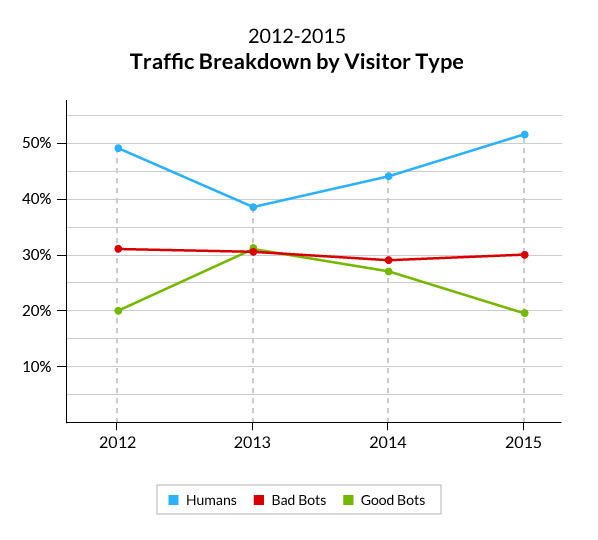

Bei der Analyse der vorliegenden Daten konnte festgestellt werden, dass – zum ersten Mal – Menschen diejenigen waren, die für die Mehrheit (51,5 Prozent) des gesamten Online-Verkehrs verantwortlich sind.

Diese Zahlen wirkten anfänglich wie eine komplette Umkehr des ursprünglichen Trends. Bei näherem Hinschauen, und in Zusammenhang mit vorherigen Analysen, wurde jedoch deutlich, dass sie in Wirklichkeit lediglich die Weiterführung einer bereits zuvor wahrnehmbaren Tendenz sind:

- Eine Steigerung des relativen menschlichen Traffics von 38,5 % in 2013 zu 51,5 % in 2015.

- Eine Abnahme des relativen Traffics durch gute Bots, von 31 % in 2013 zu 19,5% in 2015.

- Ein statischer Anteil von schlechten Bots, der ungefähr um 30 % schwankt.

Wichtig anzumerken ist hierbei, dass all diese Zahlen relativ sind. Das bedeutet, dass jede der Gruppen nur im Stande ist, auf Kosten einer anderen zu wachsen. Es ist auch wichtig zu erwähnen, dass – absolut ausgedrückt — die bloße Menge der Bots und des auf Menschen zurückzuführenden Traffics im Netzwerk kontinuierlich zunimmt.

Daher lautet die Frage hier nicht: Warum sind gute Bots immer weniger aktiv? Sondern eher: Warum können sie nicht mit den zwei anderen Gruppen Schritt halten?

Um dies zu beantworten, musste noch tiefer in die Datenbasis eingedrungen werden. Dabei konnte folgendes festgestellt werden:

1. Genereller Niedergang

Die erste Annahme war, dass die Abwärtstendenz des Traffics durch gute Bots einem individuellen Bot oder einer speziellen Gruppe von Bots zugeschrieben werden konnte, wie Imperva Incapsula es im letzten Jahr mit RSS-Bots erkannt hat. Um diese Theorie zu prüfen, hat das Unternehmen einen jährlichen Vergleich aller guten Bots durchgeführt.

Dieser Vergleich hat gezeigt, dass sich die Abwärtstendenz mit 442 von 484 guten Bots, die eine negatives Wachstum oder ein äußerst niedriges Wachstum von weniger als 0,01 Prozent zeigten durch alle Gruppen durchzog. Keine von ihnen ist um mehr als 2% zurückgegangen. Von 42 guten Bots die eine stärkere Aktivität zeigten, zeigte nur einer eine Zunahme von mehr als einem Prozent.

Grundsätzlich wurde erkannt, dass gute Bots nicht mit dem Wachstum des menschlichen und des Traffics durch schlechte Bots mithalten können.

2. Können auf populären Seiten nicht mithalten

In einem nächsten Schritt wurde eine näherer Blick auf die Websites in der Beispielgruppe geworfen.

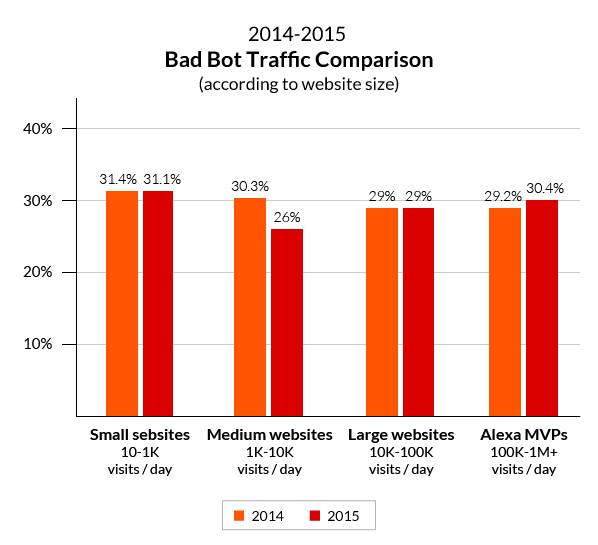

Im letzten Jahr wurden Seiten auf Basis der Menge an täglichen Besuchern segmentiert, um Website-Betreibern dabei zu helfen, ihre eigene Bot-Situation besser zu verstehen. In diesem Jahr hat sich Imperva Incapsula dafür entschieden, jene Statistiken als Basis für eine jährliche Analyse zu verwenden.

Dabei sollte identifiziert werden, ob der Niedergang des Bot-Traffics für einige dieser Website-Gruppen besonders stark ausfiel.

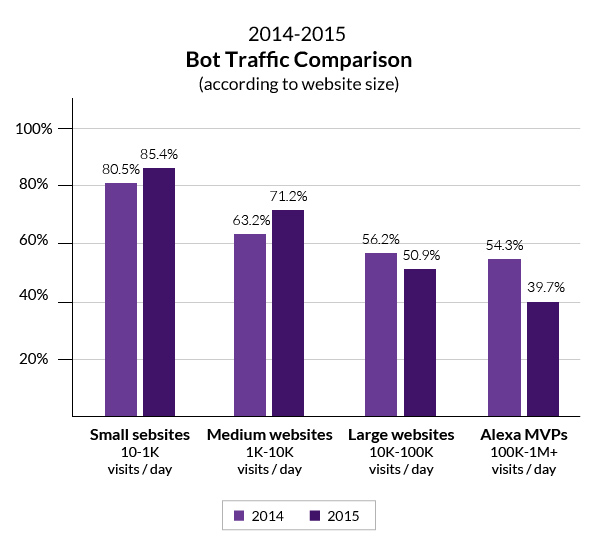

Nach der Analyse wurde eine asymmetrische Abnahme im Bot-Traffic, mit einem steigenden Traffic zu kleineren und mittelgroßen Websites, und einer Abnahme des Traffics zu größeren und populäreren Websites erkannt.

Am bedeutendsten war dabei, dass der Bot-Traffic zu den populärsten Websites (diejenigen mit 100.000 täglichen Besuchen oder mehr) von 54,3 Prozent auf 39,7 Prozent gefallen ist.

Im nächsten Schritt wurden der gute und schlechte Bot-Traffic noch einmal näher angeschaut. Dort konnte festgestellt werden, dass ein Niedergang des jährlichen guten Bot-Traffics nur auf den stark frequentierten Websites zu verzeichnen ist.

Am bemerkenswertesten war, dass auf Websites mit 100.000 oder mehr täglichen menschlichen Besuchen gute Bot-Aktivitäten von 21,9 Prozent auf 9,3 Prozent gefallen sind. Dies stand interessanter Weise im Gegensatz zu niedrigfrequentierten Websites, bei welchen gute Bot-Aktivitäten tatsächlich gestiegen sind.

Es scheint, je populärer eine Website ist, desto schwieriger ist es für die guten Bots, mit Menschen und schlechten Bots Schritt zu halten.

Eine Frage der Motivation

Um zu verstehen, warum gute Bots populäre Seiten nicht so häufig besuchen wie Menschen, ist es wichtig, die Motivationen guter Bots zu analysieren. Ganz allgemein gesprochen gibt es zwei Hauptgründe für den Besuch eines guten Bots:

1. Willkürliche Crawler – Diese bestehen aus verschiedenen Crawlern, einschließlich Search-Engine-Bots, Marktforschungstools (z. B. Backlink-Checker), legitime Scraper (z. B. der WayBackMachine Bot) und so weiter. Diese Crawler nehmen eine Website nicht spezifisch ins Visier. Sie besuchen Domains auf regulärer Basis.

2. Gezielte Suchläufe – Hierbei wird mithilfe einer Software ein gezielter Scan durchgeführt (z.B. Uptime-Scanner, Schwachstellenscanner, Plagiatsprüfer, usw.). In beiden Fällen schlägt sich eine hohe Website-Beliebtheit nicht in einem gestiegenen Traffic guter Bots nieder.

Auch eine der früheren Studien von Imperva Incapsula hat bereits gezeigt, dass es keine Korrelation zwischen der Beliebtheit einer Website und der Häufigkeit von Google-Bots Besuchen gibt. Dies gilt auch für die Mehrheit der Crawler. Man könnte zwar logischerweise davon ausgehen, dass eine populäre Website häufiger gezielt gescannt wird, jedoch ist die eigentliche Menge an zusätzlichen Scans nur unwesentlich.

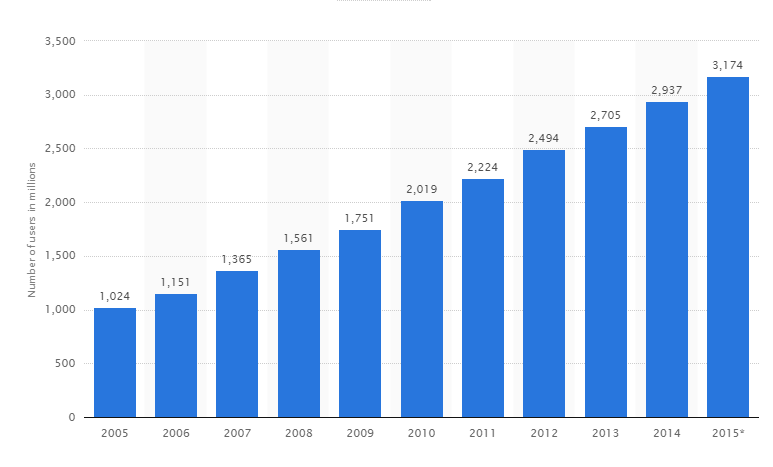

Aber während gute Bots keine Präferenzen in Bezug auf populäre Inhalte haben, haben Menschen diese sehr wohl. Je populärer eine Website wird, desto schneller wachsen auch seine menschlichen Besucherzahlen – das beschleunigte Wachstum ergibt sich aus wiederholten Besuchen und dem wachsenden viralen Erfolg durch ebenfalls kontinuierlich wachsende Social Media-Plattformen.

Außerdem wächst die Anzahl der Internetnutzer kontinuierlich, wie gezeigt, im Laufe des letzten Jahres um ungefähr 8,1%. Und auch die Zeit die online verbracht wird ist gestiegen.

Internetnutzer weltweit in Millionen (Source)

Die Verbundwirkung dieser Wachstumstendenzen und die Tatsache, dass nur Menschen dazu motiviert werden, populäre Inhalt zu konsumieren und zu teilen, sind der Grund, warum gute Bots — die diese Motivation nicht haben — einfach nicht mithalten können.

Schlechte Bots sind so aktiv wie immer

In Anbetracht der obengenannten Tendenzen ist es interessant festzustellen, dass keine Abnahme der Aktivitäten durch schlechte Bots, weder auf kleineren oder populäreren Websites verzeichnen werden konnte.

Hierfür gibt es mehrere Hauptgründe:

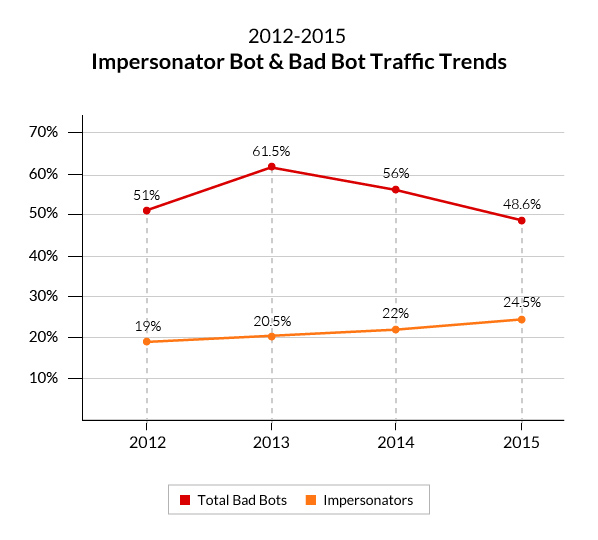

- Im Gegensatz zu guten Bots werden schlechte Bots von Personen und nicht von Organisationen genutzt. Infolgedessen steht ihr Wachstum in engem Zusammenhang mit der Steigerung der Internetnutzer.

- DDoS-Tools und DDoS-for-hire-Services, die einen Zuwachs des DDoS-Traffics verursachen, sind breit verfügbar. Kürzlich hat Imperva Incapsula hierdurch eine vierteljährliche Zunahme der DDoS-Bots von 121,9% festgestellt, die hier als ‘Impersonators’ kategorisiert werden. Nicht überraschend ist, dass dies auch die einzige Bot-Gruppe ist, die in den letzten vier Jahren ein konsequentes Wachstum verzeichnen konnte.

- Auf jeden Internetnutzer aus Industrieländern kommen zwei Internetnutzer aus Entwicklungsländern. Branchenberichte, zeigen immer wieder, dass Entwicklungsländer den Mittelpunkt für Botnet-Aktivitäten bilden, was auf eine breitere Verfügbarkeit von schlecht gesicherten, verbundenen Geräten schließen lässt.

Infolgedessen werden Websites aller Größen ins Visier genommen und auf jeden zweiten menschlichen Besucher kommt ein böser Bot-Besucher.

Diese Bots stellen weiterhin eine ernste Bedrohung für das Internetökosystem dar. Das Ausmaß dieser Bedrohung ist immens: An jedem Tag sind mehr als 90 Prozent aller sicherheitsrelevanten Ereignisse im Netz auf schlechte Bots zurückzuführen.

Von Spam-Bots lernen

Mit welchen Mitteln kann man nun die Bedrohung durch böswillige Bots minimieren? Individuell können Website-Betreiber schlechten Bots mit Sicherheitslösungen wie der von Imperva Incapsula entgegentreten, die Schutz vor Application-Layer-Attacken bieten. Diese Lösungen schützen auch vor automatisierten Hacks, Scraping, Spamming und Angriffen von DDoS.

Grundsätzlich können Sicherheitslösungen allerdings nur die Symptome, nicht die Ursachen bekämpfen, nämlich den schnellen Wachstum von Botnets, die zu immer häufigeren automatisierten Angriffen führen.

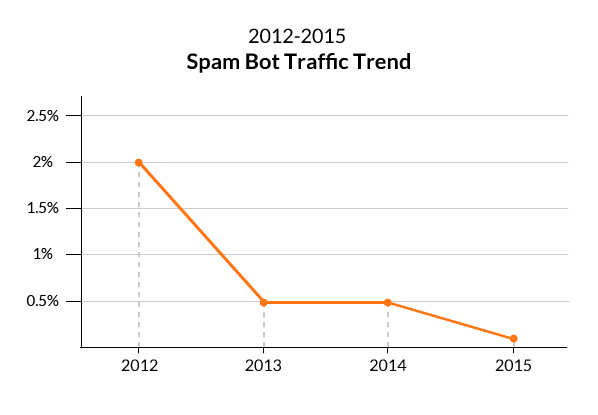

Es ist naiv zu glauben, dass solche schlechten Bots völlig ausgelöscht werden könnten, doch es gibt Möglichkeiten, die Motivation für böswillige Aktionen zu verringern über die das Wachstum generiert wird. Hierfür muss nur einen Blick auf die Geschichte von Spam-Bots geworfen werden, sprich auf eine Gruppe von schlechten Bots, die einen radikalen Niedergang von 2,0 Prozent in 2012 auf 0,1 Prozent in 2015 erlebt haben.

Vor 2012, wurden Spam-Bots im Allgemeinen durch Black Hat-SEOs verwendet, um Links auf Dutzenden, Hunderten oder sogar Tausenden von Domains auf einmal zu platzieren. Ihr Ansporn war es, die Suchmaschinenoptimierung ihrer Domains durch die Spam-Links zu verbessern, wodurch diese in den Suchergebnissen (SERP) besser gerankt wurden.

Seit April 2012 haben sich die Dinge jedoch geändert, denn Google hat derartigen Spam-Maßnahmen mit seinen Pengiun-Updates den Krieg erklärt. Die Änderung im Algorithmus hat all jene Websites bestraft, die am Spamming beteiligt waren — nicht nur diejenigen die von den Spam-Links profitiert haben, sondern auch diejenigen, die sie gehostet haben.

Mit diesem neuen proaktiven Ansatz hat Google Spam-Links in eine riskante Maßnahme ohne Aussicht auf Erfolg verwandelt. Darüber hinaus wurden Website-Betreiber dazu angeregt, ihre Anti-Spam-Maßnahmen zu verschärfen um zu verhindern, wegen Spam-Links auf ihrer Website bestraft zu werden.

Diese Nulltoleranz-Strategie, die das Sicherheitsbewusstsein und die individuelle Verantwortung fördert, sollte auch auf andere Aspekte der allgemeinen Online-Aktivitäten angewandt werden.

Zum Beispiel könnten Industriestandards eingeführt werden, um eine bessere Sicherheit von verbundenen Geräten zu gewährleisten, welche durch einen nachlässigen Umgang zur Schaffung von Botnets führen können, die wiederum schlechte Bots erzeugen. Darüber hinaus könnten sich Gerichte und Verbraucher grundsätzlich gegen Verhandlungen mit Cybererpressern aussprechen, womit eine der Hauptmotivationen für Hacker vollkommen eliminiert würde.

In diesem Jahr äußerte das Weiße Haus erstmalig Sorgen über die Botnet-Tätigkeiten. Während Strafverfolgungen in den Vereinigten Staaten und der EU kaum andere Täter abschrecken werden, sind solche Schritte dennoch wichtig, um ein Bewusstsein zu schaffen und eine ernsthafte Diskussion über schlechte Bots, ihren Ursprung, MO und Schadenspotenzial zu führen.

Was jedoch immer noch fehlt, sind Grundregeln, die durch private und öffentliche Sektoren umgesetzt werden können. Diese Regeln müssen definieren, wie mit der Bedrohung durch Botnets umgegangen werden soll und wie diese beherrscht werden können.

Methodik

Die hier präsentierten Daten basieren auf einer Probe von mehr als 19 Milliarden Menschen und Bot-Visits, die im Laufe einer 90-tägigen Periode vom 24. Juli 2015 bis zum 21. Oktober 2015 gesammelt wurden. Sie wurden von 35.000 Incapsula-geschützten Websites gesammelt, die einen täglichen Traffic von mindestens 10 menschlichen Besuchern vorweisen können.

Der jährliche Vergleich stützt sich auf die für den letzten Bot-Traffic Report gesammelten Daten, die sich aus einer Probe von mehr als 15 Milliarden Menschen und Bot-Visits zusammensetzten, die im Laufe einer 90-tägigen Periode vom 2. August 2014 bis zum 30. Oktober 2014 gesammelt wurden. Diese Probe wurde von 20.000 Incapsula-geschützten Websites gesammelt, die einen minimalen täglichen Traffic von 10 menschlichen Besuchern vorweisen können.

Geografisch schließt der beobachtete Traffic alle 249 Länder der Welt ein, sowie Territorien oder Bereiche von geografischem Interesse (durch per ISO 3166-1 Standard zur Verfügung gestellte Codes).

Die Analyse wurde durch die Incapsula Client Classification Engine unterstützt — eine eigene Technologie, die Quervergleiche anhand von Faktoren wie dem HTTP-Footprint, Ursprung einer IP-Adresse und Verhaltensmustern durchführt, um eingehenden Web-Traffic zu identifizieren und klassifizieren. Die Client Classification Engine von Imperva Incapsula wird auf allen Incapsula-geschützten Websites als ein Teil der Multi-Tier Security Lösung eingesetzt.

Quelle: Imperva Bot Report 2015